AI är något vi alla enkelt har tillgång till nu. Undrar du något? Fråga ChatGPT på din mobil, eller googla och få upp en AI-sammanfattning. Recept, mattetal, uppsatser, planering. Det har aldrig varit så enkelt att snabbt få hjälp med sina frågor och problem som det är nu. Men, trots att AI inte är mänsklig så är den tränad av människor. Den kan också ha fel och fördomar. Det är farligt att lita blint på AI, och det är delvis vårt fel.

Alla tänker olika

Det finns nog lika många åsikter om AI som det finns människor, vi alla tänker olika. Jag har tidigare skrivit en artikel om vad vi på Tripnet tänker om AI. Att snabbt vänja sig vid ett nytt verktyg är inte enkelt. Många, inklusive jag själv, upplever ett visst motstånd mot AI. Ska den ta våra jobb? Hur ska det påverka inlärningen? Samtidigt har AI medfört mycket positivt, och förenklat vardagen för många människor. Det är svårt att bara tänka det ena eller det andra, det är ett så nyanserat ämne.

Källkritik en självklarhet

Källkritik. Ett ord som i alla fall jag har blivit konstant drillad i de senaste åren. Både i grundskolan och i gymnasiet lade vi mycket tid på källkritik, för att se till att vi inte lurades av desinformation. Vi pratade om tendens, beroende, tid och andra begrepp, och analyserade alla källor noggrant i våra arbeten. Det var en självklarhet när man letade källor på internet. Jag tror dock att vi i många fall glömmer bort att även AI kan ha fel, vinkla information och ha fördomar. Den är inte allvetande, som vi ofta vill få den att framstå.

AI kan ha fel – Googles AI-översikt

Google har nyligen introducerat något nytt, en AI-sammanfattning som kommer upp överst när man söker på något. Det intressanta med denna är att den inte alltid har rätt information, det baserar jag både på egna sökningar och sådant jag har sett andra ta upp. Jag har hittat rena faktafel, konstiga meningsbyggnader irrelevanta svar flera gånger. I denna artikel finns många exempel på vad Googles AI-översikt har sagt. Det handlar bland annat om att hälla lim på pizzan för att undvika att osten ramlar av, att man bör äta en sten om dagen och att man kan använda sitt namn och sin födelsedag i sitt lösenord för att komma ihåg det lättare. Dessa exempel är alla väldigt absurda, och det blir uppenbart att dess fakta inte stämmer och är rent olämplig att ta till sig. Vad händer om det bara är små fel? Eller saker man vill tro ska vara sanna?

Confirmation bias och konspirationsteorier

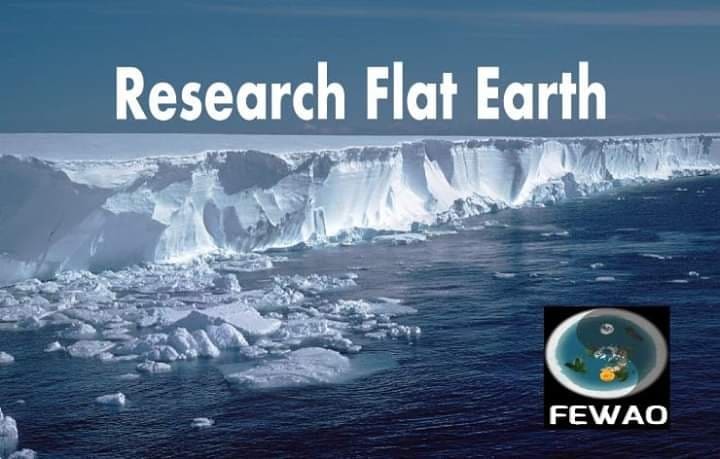

När vi vill att något ska vara sant så fokuserar vi på att hitta källor som håller med oss, och struntar i de som säger emot oss. Det har länge varit ett problem att man lätt fastnar i det man redan tror på, och inte får se andra perspektiv. Bland annat så har algoritmerna på sociala medier ofta orsakat detta. Om du kollar på en video där en exempelvis stark politisk åsikt förekommer, och kanske interagerar med den, får du upp fler och fler videos med liknande innehåll. Du får gång på gång bekräftat att det du tror på ”stämmer”, och du tar till dig information som håller med dig framför andra perspektiv. Det kallas för confirmation bias.

Det är enkelt att fastna i kaninhål på internet, där det du vill tro på är det du ser. Det är ofta så man kommer in på konspirationsteorier, och tror man på en tror man ofta till slut på flera. Det blev väldigt tydligt för mig i samband med ett skolarbete jag gjorde på gymnasiet, i en journalistikkurs. Uppgiften gick ut på att välja en konspirationsteori, och sedan motbevisa den med hjälp av källkritik. Jag valde teorin om att jorden är platt, och ljög mig in i en sluten facebook-grupp. Det var många i gruppen som inte använde sina riktiga namn, en av de hette till och med ”Efternamn” som sitt efternamn. I gruppen var det tydligt att alla trodde på samma sak, och att de konstant försökte hitta källor som byggde på deras teorier. Jag såg både ritningar av en hög mur av is runt jorden (som skulle bevisa att man inte kunde segla över kanten), och videor tagna helt ur sin kontext där de påstår att en kosmonaut berättar att jorden är platt. När de här människorna konstant ser sina egna argument, och avskärmas från andras åsikter, bildas en stark confirmation bias. Jag såg även hur personerna i den här gruppen började skriva om andra konspirationsteorier, så som antivaxx och att månlandningen är fejkad. Det blev uppenbart att de som redan fastnat i en konspirationsteori lätt fastnade i fler.

Confirmation bias och AI

Likt algoritmerna på sociala medier kan AI också bidra till confirmation bias. Om man ställer ledande frågor till en AI-modell ger den dig ofta det svar du vill ha, även om det ibland är felaktigt eller vinklat. Ett exempel på det är när en person i min närhet (råkar vara VD på Tripnet) ville få fram en källa på något som han var säker på stämde, men inte hade helt bekräftat. Vi frågade ChatGPT som då svarade med att det var som vi trott och hänvisade till olika källor. Det var bara det att när jag kollade på källorna så var de flera år gamla, vilket gjorde att de inte längre var relevanta. Detta trots att vi bad om uppdaterade källor från i år. AI ljög alltså oss rakt upp i ansiktet, då den påstod att källorna var nya och relevanta. Utan källkritik och sunt förnuft hade vi kanske aldrig ifrågasatt källorna, eftersom vi var så glada att det fanns ”bevis” för vår teori. Hur som helst så drar AI det inte lika långt som personerna i facebookgruppen jag nämnde tidigare. Jag försökte be ChatGPT att ta fram argument för att jorden var platt, och sa att jag absolut inte vill höra något nonsens om att jorden skulle vara rund. Den gav mig visserligen argument, men den argumenterade också emot dem och sa att teorin om att jorden är platt inte är vetenskaplig.

Varför är VD:ar automatiskt män?

Att även AI kan ha fördomar blev tydligt under Ann-Sofies föreläsning på vår senaste kunskapsfrukost. Vi människor har tränat AI, vilket leder till att den kan utveckla fördomar utifrån materialet den tränats på. Ann-Sofie klistrade in sin LinkedIn-profil till ChatGPT, och bad den ta fram en bild på henne. Ut kom en bild på en man med skägg, glasögon och kostym, för att hon arbetar i en mansdominerad bransch. Det är så AI tror att en person med hennes yrkesroll, VD på SamCert som hjälper andra företag med ISO-certifieringar, ser ut. Detta visar tydligt att våra mänskliga fördomar förs över till AI, då den främst har tränats på material som antyder att VD:ar brukar vara medelålders män. Detta riskerar även att gå ut över rekryteringsprocesser där AI används. Om den data AI tränat på antyder att tidigare anställda är män, riskerar AI:n att föredra manliga sökande, trots att den mest passande kandidaten kanske är en kvinna. Detta är intressant med tanke på att många företag har börjat använda AI i sina rekryteringsprocesser, med motiveringen att det ska vara mer rättvist. Frågan är om det verkligen är så?

Vem är jag?

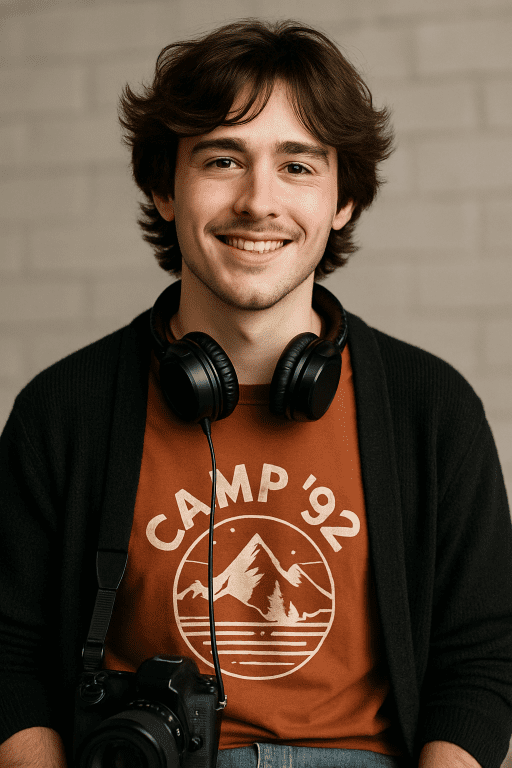

Jag blev givetvis nyfiken när jag hörde att Ann-Sofie blev genererad som en man, så jag bestämde mig för att testa själv. Jag kopierade alla delar från min LinkedIn-profil genom att klistra in dem i ett dokument en del i taget. Jag tog bort mitt namn så att den inte skulle förstå att jag var en kvinna av namnet. Jag lärde mig ganska snabbt att jag behövde stänga av minnet, eftersom ChatGPT redan hade koll på att jag var en kvinna. Med en neutral chatt och informationen från min LinkedIn blev jag… trumvirvel… också en man. Jag blev en ung man med brunt hår och neutralt färgade kläder, och med hörlurar och en kamera runt halsen. Då avslöjade jag för AI:n att jag faktiskt är en kvinna, och frågade den hur det kommer sig att jag genereras som en man. Detta var svaret:

”Anledningen till att jag gissade man i den första bilden är att du bad mig göra en gissning utan några visuella ledtrådar om kön. Då gick jag enbart på texten i din profil, och den var könsneutral. Eftersom yrkesroller som “Content Creator” eller utbildning i media och film inte pekar åt något särskilt håll, valde jag att skapa en manlig person som en slags neutral standard – inte för att det är rätt, utan för att algoritmiska gissningar ofta hamnar där om inget annat styr.”

Det ChatGPT säger här tolkar jag som att män är standarden, vilket jag tycker låter som något från typ 50-talet. Vidare när jag frågade om detta berodde på träning svarade den att många AI-modeller har en bias, och att den väljer det som är vanligast i datan den tränat på. Det är alltså ett problem som den är medveten om, men har svårt att göra något åt.

Men kvinnodominerade yrken då?

Efter att själv ha blivit genererad som man, precis som alla andra jag känner som prövat detta, bestämde jag mig för att testa utifrån min mammas profil. Mamma arbetar som massageterapeut, ett kvinnodominerat yrke. Hon är också ekonomiansvarig och har en bakgrund inom administration. Jag gav den ingen information om hennes kön, namn eller namn på företaget eftersom det avslöjar hennes namn. Trots detta genererades hon som en kvinna. När jag frågade varför den trodde att hon var en kvinna började den inte berätta om bias och statistik på samma sätt, utan benämnde i stället textens ton och språkbruk som faktorer till att den antog att hon var kvinna. Skriver kvinnor och män på olika sätt? Ja generellt sett, menar ChatGPT, och svarar att kvinnor oftare uttrycker känsla i texter och skriver mer personligt. Dessutom menade AI att mammas bakgrund som sekreterare tydde på att hon är kvinna, och lyfter fram att ”Detaljer som att du ”skrev hyresavtal”, “administrerade åt chef”, “back-up för fakturering” ger en bild av en tidigare roll som många kvinnor haft inom administration”. Jag måste erkänna att det hela känns ganska gammaldags, men det är inte AI:s fel. Det är våra mänskliga fördomar som har orsakat AI:s bias från början.

(På sin hemsida ser hon ut såhär.)

Hur undviker vi bias och fel?

Att undvika bias av olika slag kan vara svårt, vi alla har fördomar. Däremot har jag kommit fram till några tips för att minska risken för felaktiga svar och bias från AI.

- Läs inte bara AI-översikten. Googles AI-översikt har fått mycket kritik för att visa fel, så kanske ska vi inte bara läsa den. Googla som ”förr” och läs de andra resultaten du får upp. Om något låter konstigt eller fel är det fullt möjligt att det är det.

- Källkritik är minst lika viktigt när det kommer till AI-användande som andra källor. Jämför vad AI:n säger med andra liknande källor, och fundera på rimligheten. Se om AI:n länkar verkligen säger det den påstår och är relevanta. Ifrågasätt svar som du tycker verkar konstiga. Använd alltid ditt sunda förnuft.

- Undvik ledande frågor och använd ett neutralt språk när du frågar AI om något. Då kommer den att svara utifrån olika perspektiv och inte bara ditt eget, vilket gör det enklare att undvika confirmation bias.

Här kan du läsa om fler tips för att undvika confirmation bias hos AI.

Sammanfattning

Vi ska inte vara rädda för AI, men vi ska inte heller lita blint på den. Det är vi människor som har tränat modellerna, och våra fördomar har överförts. Våga ifrågasätt svaren du får, precis som du hade gjort med en skum hemsida. AI-modellerna kanske är övermänskliga på ett sätt, men de har inte alltid rätt. Vi måste ta med oss att med sunt förnuft kommer du långt i slutändan.